Campus-Backbone 2004

Einleitung

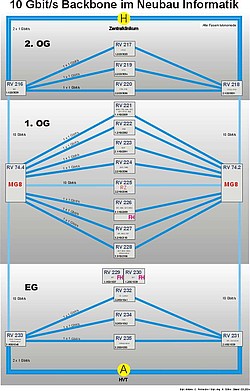

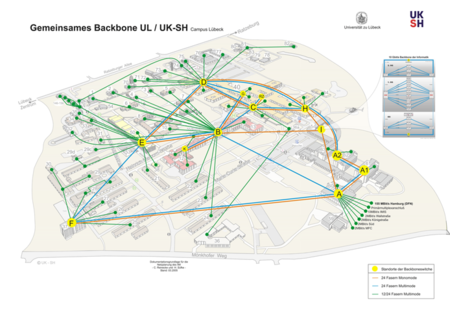

Nachdem im Rahmen der zweiten Ausbaustufe des Lübecker Krankenhauskommunikationssystems im Jahr 2000 ein flächendeckendes Hochgeschwindigkeitsnetz konzipiert wurde, entstand mit dem Neubau Informatik die Anforderung für ein neues, leistungsfähiges Teilnetz. Bei der Planung des neuen Teilnetzes mussten die besonderen Anforderungen der Informatik berücksichtigt werden. Entstanden ist ein zukunftssicheres Backbone mit 10 Gbps und der Möglichkeit, in Zukunft die Backbonegeschwindigkiet auf 40 Gbps zu erweitern. Weiterhin ist es möglich, neben IPv4 auch IPv6 in Hardware zu routen und an jedem Standort mindestens 16 Ports GE in Kupfer für die Nutzer zur Verfügung zu stellen. Das neue Teilnetz wurde als redundantes Layer 3 Teilmesh mit OSPF-Multipathrouting (host based) realisiert und verfügt so über eine hohe Ausfallsicherheit. Jeder Standort (Institut) ist mit mind. 2 x 1 Gbps an das Backbone angebunden. Der Anschluss an das Campusnetz erfolgt redundant über zwei Gegenstellen, die jeweils über je zwei GE-Trunks angeschlossen sind. Der Betrieb von verteilten Systemen ist durch die hohen Bandbreiten bis zum Arbeitsplatz in Echtzeit möglich. In dem neuen Teilnetz ist ein flächendeckendes Accounting mit Hilfe von sFlow nach RFC3176 realisierbar. Darüber hinaus ist es mit sFlow möglich, Viren und Würmer, sowie Angriffe auf das Rechnernetz zu erkennen.

1.Operative Umgebung im Local Area Network (LAN)

Im Folgenden wird der aktuelle Stand der Verkabelung beschrieben.

1.1 Verkabelung

Die Verkabelung für das Teilnetz wurde von der GMSH in Zusammenarbeit mit dem Institut für Medizinische Informatik vorgenommen.

1.1.1 Primärverkabelung

Die Primärverkabelung bildet das Backbone des Teilnetzes. Gemäß den existierenden Standards wurde die Primärverkabelung mit einem 24-adrigen Lichtwellenleiter (LWL) vom Typ Monomode (9 µm) realisiert.

Auf den Monomodestrecken ist eine Übertragung mit 10 Gbps möglich. Die maximal überbrückbare Entfernung ist vom verwendeten GBIC abhängig, siehe dazu Tabelle 1: Längenstandards. Die Ausfallsicherheit wird über redundante Verbindungen gewährleistet.

Tabelle 1: Gigabit-Ethernet 1000 MBit/s

| Art | Modus | Medium | max. Länge |

|---|---|---|---|

| 1000Base-TX | Voll-Duplex | Twisted Pair (8 Adern) | 100 m |

| 1000Base-SX | Voll-Duplex | Multimode LWL | 500 m |

| 1000Base-LX | Voll-Duplex | Monomode LWL | 10 km |

| 1000Base-ZX | Voll-Duplex | Monomode LWL | 70 km |

Tabelle 2: 10 Gigabit-Ethernet 10 GBit/s

| Art | Modus | Medium | max. Länge |

|---|---|---|---|

| 10GBase-LX4 | LAN Voll-Duplex | Multimode LWL 1310 nm | 300 m |

| 10GBase-LX4 | LAN Voll-Duplex | Monomode LWL 1310 nm | 2-10 km |

| 10GBase-SR | LAN Voll-Duplex | Multimode LWL 850 nm | 300 m |

| 10GBase-LR | LAN Voll-Duplex | Monomode LWL 1310 nm | 10 km |

| 10GBase-ER | LAN Voll-Duplex | Monomode LWL 1550 nm | 40 km |

| 10GBase-SW | WAN Voll-Duplex | Multimode LWL 850 nm | 300 m |

| 10GBase-LW | WAN Voll-Duplex | Monomode LWL 1310 nm | 10 km |

| 10GBase-LW4 | WAN Voll-Duplex | Monomode LWL 1310 nm | 40 km |

| 10GBase-EW | WAN Voll-Duplex | Monomode LWL 1550 nm | 40 km |

1.1.2 Sekundärverkabelung

Über die Sekundärverkabelung werden die Knotenpunkte in den einzelnen Instituten mit dem Backbone verbunden. Die Sekundärverkabelung erfolgt ebenfalls auf der Basis von Lichtwellenleitern vom Typ Monomode 9 µm mit 24 Fasern. Jedes Institut ist redundant am Backbone angebunden.

1.1.3 Tertiärverkabelung

Die Tertiärverkabelung verbindet die Knotenpunkte in den einzelnen Instituten mit den Endgeräten an den Arbeitsplätzen. Die Tertiärverkabelung erfolgt mit Kupferkabeln und teilweise mit LWL. Eingesetzt werden Twisted Pair Kabel der Kategorie 7 mit Anschlussdosen der Kategorie 6.

2. Beschreibung der Hard- und Software

Einige wesentliche Merkmale der aktiven Komponenten des Datennetzes sind im Folgenden aufgeführt.

2.1 Hardware

Alle eingesetzten Geräte sind modular aufgebaut und mit redundanten Netzteilen ausgestattet. Das Backbone wird von Switchen mit 10GE Modulen gebildet.

- Es wurden sieben modulare Backboneknoten mit 10GE Anschlüssen von Foundry Networks verbaut. Davon sind zwei Geräte vom Typ BigIronMG8 (acht Slots) und fünf Geräte sind vom Typ BigIron15000 (16 Slots), die mit 10 Gbps untereinander verbunden sind.

- Alle 13 modularen Workgroupswitche sind voll Layer3-fähig und in der OSPF-Area des Backbone eingebunden und mit mind. 48 x 10/100 Mbps TP-Ports, 16 x 100/1000 Mbps TP-Ports und 6 x GE-LWL-Ports ausgestattet. Die Switche sind vom Typ BigIron15000 von Foundry Networks.

- Verwendete Einschubkarten in den modularen Systemen: 4 x 10GE LWL, 2 x 10GE LWL, 40 x 1GE LWL, 8 x 1GE LWL, 16 x 100/1000 Mbps TP und 48 x 10/100 Mbps TP.

- Die GE-Einschubkarten sind mit GBICs modular bestückbar.

- Bis auf die 16 x 100/1000 Mbps Karte gibt es keine statistische Überbuchung auf L2 und L3 – die Verbindungsgeschwindigkeit zur Backplane beträgt pro Slot 8 Gbps.

- Die Netzteile und Einschubkarten sind im laufenden Betrieb austauschbar.

- Die Netzteile, und teilweise auch die zentralen Managementeinheiten, sind redundant ausgelegt.

Insgesamt sind die Switch-Systeme mit 12 Ports 10 GE, 232 Ports 1000Base-SW/LX, 288 Ports 1000Base-T und 1440 Ports 10/100Base-TX bestückt.

Der Vorteil bei einem modularen System liegt darin, dass ein weiterer Ausbau ohne Performanceverluste möglich ist, da jede weitere Einschubkarte mit 8 Gbps an die non-blocking Backplane angeschlossen wird. Da bei einem Ausfall eine defekte Karte ausgetauscht werden kann, ohne dass Konfigurationsschritte nötig sind, wird der Betrieb vereinfacht. Die Ausfallzeit wird dadurch weiter reduziert. Die Netzteile sind redundant ausgelegt. Eines ist mit einer USV verbunden, eines direkt mit dem Stromnetz. So werden Störungen am Stromnetz, so wie mögliche Fehler an der USV, kompensiert.

2.2 Software und Features

Genutzt werden u.a. folgende Features:

- IP wird in wirespeed gerouted

- Multicastrouting erfolgt im PIM-DM und PIM-SM

- OSPF-Multipathrouting (host-based)

- Die Administration erfolgt über SSHv2 und SNMPv1/v2/v3 (nur Abfrage) und Traps

- RMON: Statistic, History, Alarms und Events

- Class of Services (CoS)

- VLAN-Typen: Protokoll- und portbasierend

- Rapid Spanning Tree

- Spanning Tree pro VLAN

- Beglaubigung über Radius

- Syslog

- Zeitsynchronisation über SNTP

- Accesslisten und Accessprofiles

- sFlow

- IPv6

- IEEE 802.1X port based network access control

- MAC-Authentifizierung

2.3 Standards

Die Geräte unterstützen u.a. folgende Standards (Herstellerangaben):

- IEEE 802.3-1998

- IEEE 802.3ae-2002 (10Gbps Ethernet)

- IEEE 802.3z-1998 (1000Base-X)

- IEEE 802.3ab-1999 (1000Base-T)

- IEEE 802.3u (100BaseTX/FX)

- IEEE 802.3i (10BaseT)

- IEEE 802.ad-2000 (link aggregation)

- IEEE 802.1D (spanning-tree protocol, STP)

- IEEE 802.1w-2001 (rapid spanning-tree protocol, RSTP)

- IEEE 802.1s-2002 (multiple spanning tree)

- IEEE 802.1Q-1998 (VLAN trunking/tagging)

- IEEE 802.1p (filtering controls for spanning tree (Priorisierung))

- IEEE 802.3x (flow control)

- IEEE 802.2 (logical link control)

- IEEE 802.1x-2001 (port based network access control)

- sFlow nach RFC 3176

- RMON Groups 1,2,3,9 nach RFC 1757

- OSPF nach RFC: : 2178, 1583, 1587, 1745, 1765, 1850, 2154, 2328, 1850, 1997, 2385, 2439, 2842, 2918, 2370

- CIDR nach RFC 1519

- IP Multicast nach RFC: 1122, 1256, 1112, 2236, 2362, 2336, 2283

- VRRP nach FRC 2338

- SNTP nach FRC 2030

2.4 Performance

Das neue Backbone ist mit Switchen bestückt, die in der Lage sind, alle anzuschließenden Workgroupswitche mit 1 Gbps zu versorgen, ohne dabei die Backplane statistisch zu überbuchen. Wie in Tabelle 3 zu sehen ist, könnte der BigI-ronMG8 bis zu 256 GE-Ports blockierungsfrei betreiben.

Tabelle 3: Performance des eingesetzten BigIronMG8 (Herstellerangaben)

| Foundry BigIron MG8 | |

|---|---|

| Kapazität der Backplane des Switches in Gbps: | 1280 |

| forwarding Performance Layer 2 in Mpps (für IP und IPX): | 480 |

| forwarding Performance Layer 3 in Mpps (Packetgröße = 64 Byte, für IP und IPX): | 480 |

| Anzahl von GE-Ports die blockierungsfrei betrieben werden können: | 256 |

Tabelle 4: Performance der eingesetzten BigIron15000 (Herstellerangaben)

| Foundry BigIron 15000 | |

|---|---|

| Kapazität der Backplane des Switches in Gbps: | 480 |

| forwarding Performance Layer 2 in Mpps (für IP und IPX): | 178 |

| forwarding Performance Layer 3 in Mpps (Packetgröße = 64 Byte, für IP und IPX): | 178 |

| Anzahl von GE-Ports die blockierungsfrei betrieben werden können: | 64 |

3. Topologie

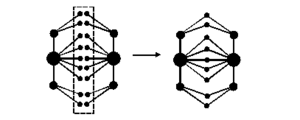

Die Topologie des Datennetzes setzt sich aus zwei Grundtypen zusammen. Sie besteht aus einer klassichen Sterntopologie, die mit einer Ringtopologie kombiniert wird.

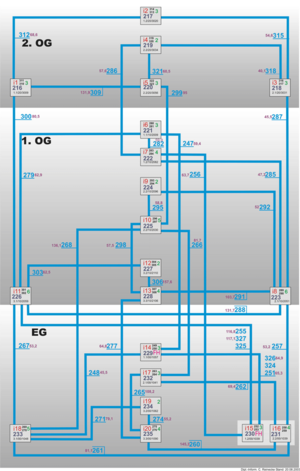

- Sterntopologie: Jeder Datennetzschrank (Rangierverteiler, RV) ist mit einem zentralen Raum im Erdgeschoss (RV74) über 24 Fasern Monomode verbunden.

- Ringtopologie: Auf jeder Etage sind die RV mit 24 Fasern Monomode ringförmig untereinander verbunden. Die Etagen wiederum stehen durch drei unabhängige Leitungen miteinander in Verbindung.

3.1 Ethernet als Medienzugangsprotokoll

Auf den oben genannten Topologien aufbauend, wurde ein Datennetz mit Ethernet als Medienzugangsprotokoll implementiert. Die letztendlich genutzten Backbonefasern entsprechen dabei eher zwei zueinander symmetrischen Baumstrukturen, die an den Blättern miteinander verbunden sind. Siehe dazu Abbildung 5.

Durch die symmetrische Struktur kann sinnvoll ein Load-Sharing konfiguriert werden, das gleichzeitig die redundante Anbindung eines jeden Knotens gewährleistet. Um dies zu erreichen, wird auf der Vermittlungsschicht IP mit OSPF als Routingprotokoll eingesetzt. Siehe Kapitel 3.2. Die Etagen untereinander und die Verbindungen zum Rechenzentrum (in der Abbildung mit stärkeren Linien gekennzeichnet) sind mit 10 Gbps angeschlossen. Die restlichen Verbindungen sind mit 1 Gbps realisiert. Die zentralen Knoten sind mit Geräten vom Typ BigIron MG8 bestückt, die mit einer 40 Gbps Backplane ausgestattet sind. Dadurch können auch die 10 Gpbs Anschlüsse in Wirespeed betrieben werden. Siehe dazu Tabelle 2. Jedes Institut (entspricht einem Knoten) bekommt ein eigenes VLAN mit eigenem IPv4-Subnetz, z.B. 141.83.20.0/24. Sollte sich ein Institut über mehrere Knoten erstrecken, wird das VLAN redundant konfiguriert und mit „rapid spanning tree“ abgesichert.

3.2 IP als Protokoll der Vermittlungsschicht

Das Datennetz kann mit IPv4 sowie IPv6 parallel betrieben werden. Als Routingprotokoll kommt OSPF zum Einsatz. Jede Kante in der Baumstruktur entspricht einem Transitnetz (VLAN mit zwei privaten IPNummern, das geroutet wird und aktiv im OSPF konfiguriert ist). Durch Aktivierung des Load-Sharing-Modus (host-based) werden nun beide Wege mit gleichen Kosten (Hops) parallel genutzt. Fällt eine Verbindung aus, nutzt OSPF unverzüglich nur noch den verbleibenden Weg.

4. sFlow

Mit den eingesetzten Geräten ist ein flächendeckendes Accounting mit Hilfe von sFlow nach RFC3176 möglich. Mit sFlow können Informationen von Layer 2-7 gesammelt werden. Damit wird eine höhere Informationsgewinnung als z.B. über die üblichen MIBs (SNMP) oder den in Switchen üblichen RMON Implementationen ermöglicht. Durch den Einsatz von ASICs (application-specific integrated circiut) können die Informationen ohne Performanceverluste gewonnen werden. Die Informationen können z.B. genutzt werden, um Würmer, Viren und Trojaner oder P2P-Missbrauch im Rechnernetz aufzuspüren.

5. Sicherheit

Im Gegensatz zum restlichen Campusnetz, wird im Informatikgebäude für gewöhnlich kein Verwaltungsnetz benötigt. Aus diesem Grund sind an den Übergangsknoten vom Campusnetz zum Teilnetz der Informatik Routen-Filter gesetzt, so dass im Teilnetz der Informatik nur Wissenschaftsnetze (WI) geroutet werden. Zusätzlich sind im Backbone auf den Switchen Access-Listen konfiguriert, die IP-Nummern des Verwaltungsnetzes (VW) blocken. Sollte doch mal das VW-Netz benötigt werden, wird ein Subnetz aus den Übergangsknoten als VLAN zu dem entsprechenden Workgroupswitch konfiguriert.

5.1 Sicherer Betrieb des Backbone

Das Backbone routet alle ankommenden Pakete entsprechend ihres Ziels. Als Routingprotokoll kommt OSPF zum Einsatz. Zum Schutz der Routingtabellen wurde das Feature zur Authentifizierung (MD5) des OSPF-Interface aktiviert. Die Manipulation der Routen über einen fremden OSPF-Router ist so ausgeschlossen. Alle Subnetze der Nutzer sind passiv im OSPF konfiguriert. Vorsichtshalber werden im Backbone nur IP-Adressen aus dem Internet oder dem WI-Netz zugelassen. IP-Adressen aus dem privaten Adressbereich werden über Accesslisten geblockt. Die Knoten sind über Subnetze aus einem privaten Adressenbereich miteinander verbunden. Zum Konfigurieren und Überwachen der Switche ist ein spezielles Management-VLAN mit einem ebenfalls privaten Adressenbereich konfiguriert. Es ist nur möglich über dieses VLAN, in dem als Endgerät nur der Managementserver angeschlossen ist, auf die Switche zuzugreifen. Die Zugriffsregelung erfolgt über Access-Profile und Beglaubigung mit Nutzername und Passwort. Auf die Geräte wird über SSHv2 oder HTTPS zugegriffen. Die Zeit wird über SNTP synchron gehalten.

5.2 Sicherer Betrieb der Workgroupswitche

Die Workgroupswitche (WS) werden im Teilnetz der Informatik als Layer-3-Switch betrieben. Das jeweilige Subnetz eines Instituts wird auf dem WS geroutet bzw. geswitcht. Auf jedem Switch wird ein VLAN als Management-VLAN definiert. Jeder WS erhält eine IP-Nummer aus dem privaten Adressbereich des Management-VLANs über die der WS konfiguriert werden kann. Da keine Endgeräteports in das Management-VLAN definiert werden, ist der Zugriff nur von einer speziellen Managementstation aus möglich. Der Zugriff auf den WS aus dem VLAN wird über entsprechende Accessprofiles auf dem WS verhindert. Ein Zugriff auf den WS über SSH oder SNMP ist nur von der Managementstation aus dem privaten Adressbereich möglich. Der Switch holt regelmäßig über SNTP die Uhrzeit vom Managementserver, um die Logdatei konsistent zu halten. Alle Ports auf dem WS sind standardmäßig „disabled“ und müssen explizit freigeschaltet werden. Jedem VLAN wird eine Accessliste für eingehende und ausgehende Pakete zugewiesen. So wird z.B. verhindert, dass IP-Spoofing betrieben werden oder auf private Netze zugegriffen werden kann.

Zusammenfassend sind folgende Sicherheitsfeatures von Bedeutung:

- Mit Sicherheitsschlössern gesicherte Datennetzschränke

- Konsolenports sind über Passwörter geschützt – eine Wiederherstellungsprozedur ist nicht durch erneutes Booten möglich.

- Zugriffe auf den Switch über SSHv2 oder SNMP sind über Accessprofiles geregelt.

- Eine Telnetsitzung ist verschlüsselt (SSHv2).

- Automatischer Logout nach definierter Zeit.

- Zugriffe auf Rechner in Subnetzen können über Accesslisten/Paketfilter geregelt werden. Die Accesslisten können sowohl auf den Backboneswitchen, wie auch auf den Workgroupswitchen gesetzt werden.

- Beglaubigung des Zugriffs auf den Switch erfolgt über RADIUS.

- Ereignisse auf dem Switch werden zu einem Syslogserver und zu einem Trapserver geschickt.

- SNTP mit beglaubigtem Zeitserver.

- Jedes Institut besitzt ihr eigenes Subnetz (VLAN) mit eigenen Accesslisten

- Studentenpools sind extra abgegrenzt und haben nur sehr eingeschränkten Zugriff.