OMICS-Cluster

An der Universität zu Lübeck wurde für das Exzellenzcluster das OMICS-Rechencluster beschafft. Auf diesem werden primär Berechnungen für GWAS, NGS, in silico modelling usw. durchgeführt.

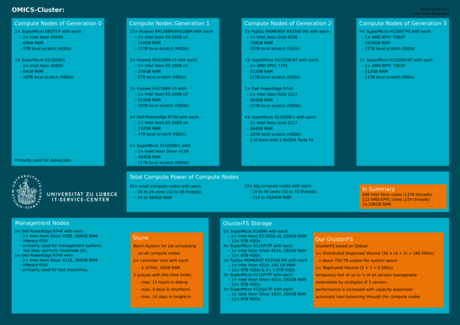

Das OMICS-Cluster stellt eine leistungsstarke Rechenplattform für die beteiligten Institute und Einrichtungen dar. In seinem jetzigen Ausbau stehen in Summe 1.600 CPU-Threads und ca. 14,3 TB Arbeitsspeicher für Berechnungen zur Verfügung. Um diese beachtliche Leistung möglichst fair zu verteilen, wird der Job-Scheduler Slurm eingesetzt, welches die Batch-Aufträge verwaltet und entsprechend zur Ausführung bringt. Dabei können ein oder mehrere Rechenknoten reserviert und genutzt werden.

Die Maschinen kommen in verschiedenen Ausführungen daher. Während einige besonders viel CPU-Kerne (bis zu 64 bzw. 72 Threads) bieten, besitzen unsere vier High-Memory-Nodes bis zu 1TB Arbeitsspeicher. Die meisten unserer Rechenknoten besitzen 32 bis 48 Threads und 192 bis 384GB RAM. Zusätzlich besitzen unsere Rechenknoten alle lokale Festplatten, um die Netzwerkdateisysteme zu entlasten und die Berechnungen zu beschleunigen. Hierbei reicht die Spanne von ca. 5TB auf Festplatten bis 15TB auf SSDs.

Für die Ablage von Projektdaten zwischen den Rechenjobs stehen insgesamt über 750 TB permanenter Speicherplatz im GlusterFS-System zur Verfügung.

Lenkungsgruppe

Mitglieder:

- Prof. Dr. Hauke Busch (Lübecker Institut für experimentelle Dermatologie, LIED, Sprecher der Lenkungsgruppe)

- Prof. Dr. Lars Bertram (Lübecker Interdisziplinäre Plattform für Genomanalytik, LIGA)

- Prof. Dr. Jeanette Erdmann (Institut für Integrative und Experimentelle Genomik, IIEG)

- Prof. Dr. Martin Kircher (Institut für Humangenetik)

- Dipl.-Inf. Helge Illig (IT-Service-Center, ITSC)

Ehemalige Mitglieder:

- Prof. Dr. Saleh Ibrahim (Lübecker Institute for Experimental Dermatology, LIED)

Anträge, Ordnungen

- Benutzerordnung (in Vorbereitung)

- Projektantrag

- Nutzermeldung

Die Geschichte des OMICS-Clusters

Die Idee des OMICS-Clusters entstand im Dezember 2014 auf einem ersten Arbeitstreffen der Professoren L. Bertram, J. Erdmann, S. Ibrahim sowie Dipl.-Inf. H. Illig. Im Mai des folgenden Jahres wurden 230.000 Euro in die erste Ausbaustufe des OMICS-Clusters investiert. Finanziert wurde dies primär durch das Exzellenzcluster Entzündungsforschung. Es umfasste das erste Storage, einen Verwaltungsknoten und 17 Rechenknoten, einer davon der Bignode mit 72 CPU-Threads. Der erste Vollzeit-Administrator des Clusters wurde im Oktober desselben Jahres Frank Rühlemann.

Im Mai 2016 bekam das Cluster seine zweite Ausbaustufe, welche eine Vergrößerung der Storagekapazität, einen zweiten Verwaltungsknoten und die Anschaffung einiger weiterer Rechenknoten umfasste. Von den dafür notwendigen 230.000 Euro wurden 40.000 von LIED beigesteuert, die restlichen 190.000 wurden von den Arbeitsgruppen Erdmann, Bertram und Lill gestellt.

Ende 2016 stieß Professor Busch zur Lenkungsgruppe und wurde zum neuen Sprecher ernannt.

Im Januar 2017 folgte die Einstellung von Gudrun Amedick als zweite Administratorin für das Cluster.

Im Laufe des Jahres 2017 wurden die ersten drei dedizierten GlusterFS-Server beschafft, um von einem Distributed Volume mit den beiden Storages auf ein Distributed Dispersed Volume (4+2) über unabhängige Standard-Server umzustellen. Dies sollte den zukünftigen Ausbau vereinfachen und die Kosten für den Austausch veralteter Hardware zeitlich besser verteilen.

Ab 2018 wurde die neue GlusterFS-Struktur jährlich durch drei Server erweitert, welche jeweils ca. 192TB neuen Speicherplatz erlauben.

Auf Nutzerwunsch hin wurde 2019 ein NFS-Speicher mit ca. 20TB Platz beschafft. Dieser erlaubt eine höhere Small-File-Performance und wird als knotenübergreifender Speicher daher z.B. für nutzerseitig installierte R- oder Python-Pakete und kleinere Datensätze genutzt. Er stellt somit ein Bindeglied zwischen dem GlusterFS-System und lokalen Festplatten der Rechenknoten dar. Zusätzlich konnten mit Geldern von Professor Busch auch die Rechenknoten modernisiert werden. So entlasteten die beiden Maschinen mit 768GB RAM den bignode (node24) während fünf kleine Rechenknoten mit 32 Threads und 384GB RAM die gestiegenen Memory-Anforderungen erfüllen konnten. Die neu aufgekommenen AMD-EPYC-CPUs erschienen sehr interessant und wurden in zwei Rechenknoten mit 32 Threads und 512 GB RAM ausprobiert.

2019 wurde auch die Datennetzanbindung deutlich verbessert.

Ein Backup sichert seit 2020 das GlusterFS besser ab. Hierfür wurde eine System mit 1,6PB Speicher beschafft, welche regelmäßig den Datenstand sichert. Drei Rechenknoten wurden mit Tesla-T4-GPUs ausgestattet, um bestimmte darauf optimierte Berechnungen deutlich zu beschleunigen und diese wurden gut angenommen. Die Rechenknotenanzahl konnte inzwischen auf 41 erweitert werden.

Organisatorisches

Helge Illig

Gebäude 64, 034 (1.OG)

Tel. +49 451 3101 2000

helge.illig(at)uni-luebeck.de

Ansprechpartner

Frank Rühlemann

Gebäude 64, 031 (EG)

Tel. +49 451 3101 2034

f.ruehlemann(at)uni-luebeck.de

Gudrun Amedick

Gebäude 64, 032 (EG)

Tel. +49 451 3101 2035

itsc.support-omics(at)uni-luebeck.de